Deze column staat in Het Financieele Dagblad van 29 november 2018. Volg deze link voor mijn eerdere FD columns.

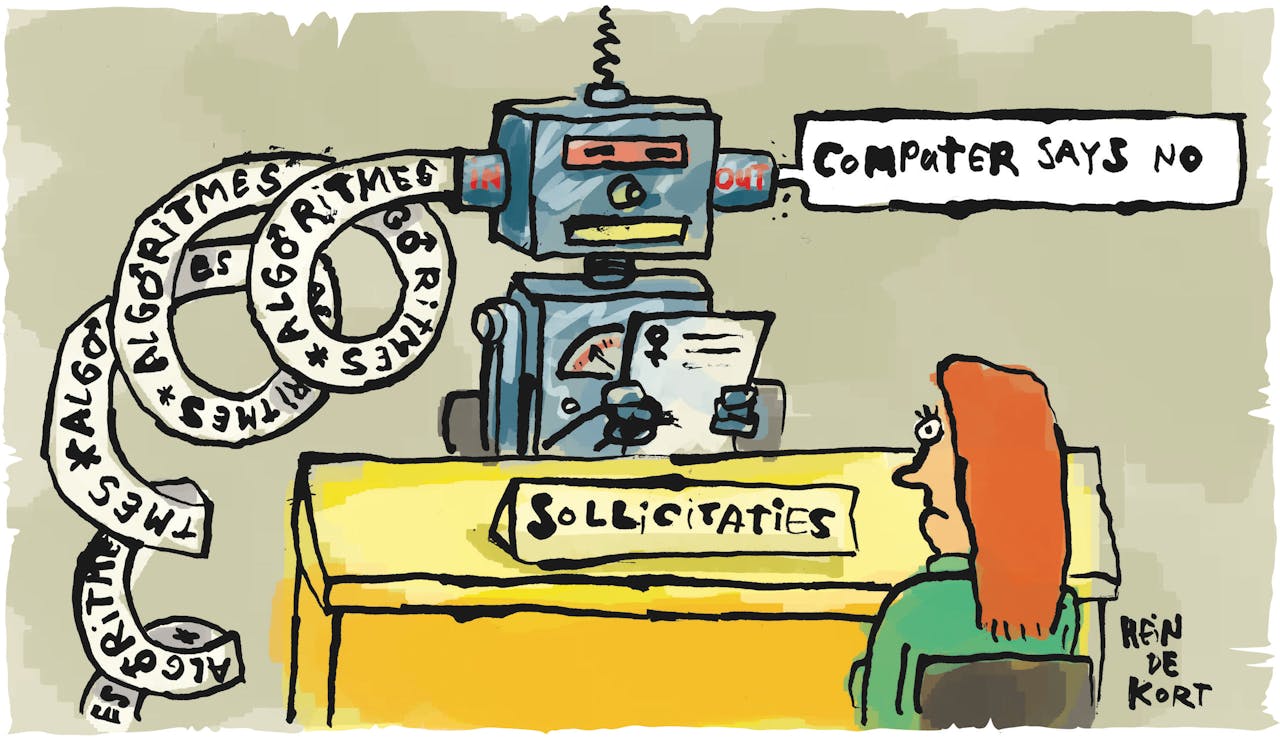

Internetreuzen als Amazon, Google en Microsoft zetten al jarenlang in op kunstmatige intelligentie (AI). Toch gaat er veel mis als zelflerende algoritmes losgaan op de werknemers, foto’s of klanten. Vorige maand onthulde Reuters dat Amazon na vier jaar een hr-tool om door cv’s van sollicitanten te scannen weer in de ban doet, omdat die consequent vrouwen discrimineert. Google toonde Afro-Amerikanen als je zocht op ‘gorilla’ en chatbot TayTweets van Microsoft ontwikkelde zichzelf binnen een dag tot een racist en complotdenker (en Trumpfan). Blijkbaar kunnen zelfs de bestbetaalde geniën bij internetreuzen hun algoritmes niet opvoeden.

Organisaties en beleidsmakers moeten lering trekken uit deze incidenten. Maak maatschappelijke waarden en heldere doeleinden onderdeel van trainingsdata en analysetools om AI succesvol en acceptabel te maken.

Kinderziekten horen bij technologische disruptie. Socioloog Manuel Castells sloeg in 1995 de spijker op zijn kop in zijn standaardwerk The Rise of the Network Society. Hij schreef dat elke technologische omwenteling gepaard gaat met ‘perverse effecten’. In de jaren ’80 en ’90 hebben geeks, bedrijven en overheden cruciale ontwerpkeuzes gemaakt die nog steeds het DNA van het internet bepalen: connectiviteit was prioriteit, iedereen moest kunnen aanhaken. Privacy en cybersecurity daarentegen werden uit de kernprotocollen van het internet gehouden. Bijkomend voordeel was dat de Amerikaanse overheid makkelijk kon meeluisteren. Maar nu zit de wereld opgescheept met de perverse effecten van 30 jaar oude ontwerpkeuzes: privacy staat onder druk, cybercrime tiert welig en iedereen bespioneert iedereen.

Gezonde verstand

Net als destijds met het internet, willen (vooral Amerikaanse) leveranciers ons weer doen geloven dat AI ‘een revolutie zal ontketenen in de wereld van x’, waarbij variabele x elke waarde aanneemt die bij een meeting, congres of pitch centraal staat. ‘Geen restricties op onze innovatie, u hoeft alleen bij het kruisje te tekenen.’ Tijdens diezelfde bijeenkomsten werd je jarenlang weggehoond als je wees op de perverse effecten van AI en regelgeving, gedragscodes of zelfs gezond verstand om de boel bij elkaar te houden.

Gelukkig lijkt het gezonde verstand langzaam terug te keren in het AI-debat. Niet alleen zorgen de incidenten voor groeiende scepsis bij afnemers. Ook de nieuwe Europese privacywet AVG vereist bij ‘geautomatiseerde besluitvorming’ altijd eerlijkheid, transparantie en uitlegbaarheid van de beslismodellen, en vaak voorafgaande expliciete toestemming van degene wiens data wordt geanalyseerd. Zonder verdere uitleg stellen dat een zelflerende hr-tool, zoekmachine of chatbot op hol is geslagen, volstaat niet langer en kan leiden tot serieuze AVG-boetes en reputatieschade.

Met de ontwerpkeuzes van vandaag leggen wij de fundamenten voor de gezonde inzet van AI in de komende decennia.

Maar hoe anticipeer je op perverse effecten bij een technologie die volop in ontwikkeling is? In zijn boek The Social Control of Technology van 1980 beschreef de Britse wetenschapper David Collingridge dit dilemma: ‘als ingrijpen op innovatie eenvoudig is, is de noodzaak nog niet duidelijk; als iedereen de noodzaak begrijpt, is ingrijpen duur, complex en langdurig.’ Hij nam onder meer benzine als voorbeeld. Bij de introductie van de auto was de milieuschade van loodhoudende benzine beperkt. Toen de auto eenmaal mainstream was, heeft het pijn en moeite gekost over te schakelen op loodvrije benzine. Het Collingridge dilemma overwin je door te investeren in kennisontwikkeling, afhankelijkheid van lobby-invloed uit te sluiten en transparant te zijn over voor- en nadelen van technologische omwentelingen.

Organisaties doen er dus verstandig aan te investeren in kennisontwikkeling, einddoelen helder te definiëren en de trainingsdata te checken op (juridische) bruikbaarheid, kwaliteit en vooringenomenheid. Zo kun je ook beter voldoen aan de AVG-vereisten. In mijn praktijk zie ik verstandige (vaak: kleine) AI-projecten razend succesvol worden en bij De Brauw helpt AI advocaten adviseren bij fusies- en overnames en in interne onderzoeken. Maar gooi je data over de schutting en hoop je op de magische saus van AI, dan stapelen incidenten zich vaak op tot teleurstellingen. Amazon, Google en Microsoft maakten de fout alleen te vertrouwen op hun briljante geeks, en sociale wetenschap, recht en diversiteit geen plek te geven aan de ontwerptafel. In hun projecten gold de nu bekende vuistregel: is de inputdata rommel, dan is de uitkomst ook rommel.

Tempo

Beleidsmakers in Nederland en Europa dienen vooral passende maatschappelijke kaders te scheppen voor AI. Waar de VS en China AI reguleren als handelspolitiek en machtsinstrument, kent Europa een sterke grondrechtentraditie. Niet geld of de Staat, maar de mens staat in principe centraal. Vermoeiend allicht, maar het zorgt voor een relatief harmonieuze, gezonde en vrije samenleving. Het verplicht namelijk perverse effecten als discriminatie en privacyschendingen vroegtijdig te voorkomen.

Tempo is een veel groter probleem in Europa en Nederland. Door een gebrek aan visie komt de noodzakelijke investering in kennis nu pas op gang en leunt het continent te veel op lobbyisten en technologie uit de VS – met cloud computing ging het tien jaar terug precies zo. De EU heeft pas net een ‘expertgroep’ (vol lobbyisten) verzameld die gaat meedenken over Europees AI-beleid. Daarmee loopt de EU minstens vier jaar achter: Amazon begon al in 2014 met het recruitmentproject. Hoog tijd voor de vijfde versnelling. Met de ontwerpkeuzes van vandaag leggen wij de fundamenten voor de gezonde inzet van AI in de komende decennia.