Deze column staat in Het Financieele Dagblad van 7 februari 2019. Volg deze link voor mijn eerdere FD columns.

Hoe succesvoller wetenschap en technologie voortschrijden, hoe ondoorzichtiger en obscuurder zij worden’. Naarmate de tijd vordert, lijkt deze diepzinnige uitspraak van de Franse filosoof Bruno Latour, uit 1999, onze hypertechnologische wereld alsmaar beter te beschrijven. De kunstmatige intelligentie (AI) van zelflerende computersystemen destilleert opzienbarende inzichten uit gigantische bergen inputdata. Tegelijkertijd lukt het ontwikkelaars van AI-systemen en wetenschappers vaak niet om vooraf te voorspellen of achteraf te verklaren hoe zelflerende systemen zulke bovenmenselijke prestaties leveren. Sterker nog: steeds vaker hoor je dat uitlegbaarheid van de werking van AI-systemen aan gewone stervelingen een rem zou vormen op de voorspellende kracht van AI.

Zwarte doos

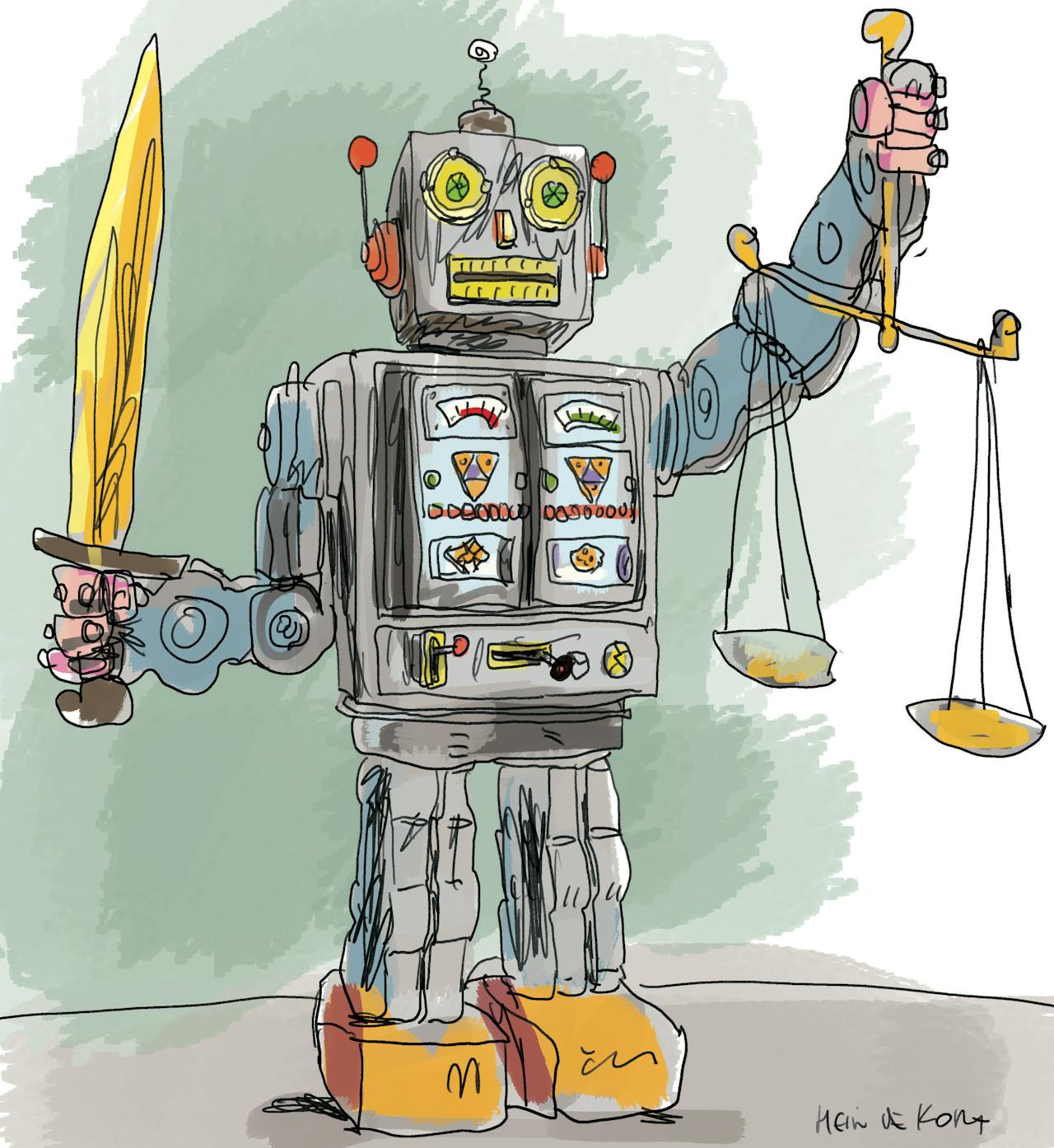

Toch beginnen wetgevers en rechters het recht als werktuig te gebruiken om de ‘zwarte doos’ van technologie en wetenschap open te breken. De strenge Europese privacywet AVG en baanbrekende rechterlijke uitspraken verlangen transparantie van inputdata en uitlegbaarheid van besluiten die door machines worden genomen. Of het nu gaat om zelfrijdende auto’s, beleggingsbeslissingen of automatische gezichtsherkenning op straat, innovatie en recht liggen op ramkoers. In tegenstelling tot het veelgehoorde determinisme van ontwikkelaars en Latour – de technologie werkt nu eenmaal zo, dus vergeet het maar met je uitlegbaarheid – zal het recht uitlegbaarheid afdwingen. Althans, in Europa.

Sinds het bestaan van computers maken wetenschappers zich zorgen over de zwarte doos van technologie. De pionierende cyberneticus Ross Ashby ontwikkelde in 1956 het concept dat de mens weliswaar de input en de output van een machine kent, maar dat de interne werking steeds obscuurder wordt. Toch zijn de recente ontwikkelingen in AI wezenlijk anders. De algoritmes die in ‘machine learning’ liggen besloten zijn namelijk niet langer een reeks door mensen ontworpen regels die tot een besluit leiden, zoals software die automatisch checkt of persoonsgegevens op een uitkeringsaanvraag voorkomen in een databank met fraudeurs. Tegenwoordig herkent AI geheel zelf (‘deep learning’) of onder begeleiding (‘supervised machine learning’) patronen uit al die data. De zelflerende software zet die patronen vervolgens om in vaak onverklaarbare besluitvorming: de computer zegt ‘nee’, dus geen uitkering.

‘Zelflerende software prefereert efficiency en optimalisatie boven rechtvaardigheid en twijfel’

Zelflerende software prefereert efficiency en optimalisatie boven rechtvaardigheid en twijfel. Dat kan controversiële en ongelijkheid versterkende beslissingen opleveren, zoals bij de geheime vrouwonvriendelijke AI-recruitmenttool van Amazon. Maar het kan ook levens redden. Neurowetenschappers publiceerden in ‘Nature’ (maart 2018) Nobelprijswaardig onderzoek, waarin zij zelflerende software loslieten op 1104 diagnoses van hersentumoren. De software ontdekte voorheen onbekende tumorsoorten én in 12,6% van de gevallen kwam de diagnose van de arts en machine niet overeen, waarvan in 92,8% van die gevallen de diagnose van de computer accurater was.

In dit tumorenonderzoek was sprake van ‘supervised machine learning’. ‘Deep learning’ gaat nog een stap verder. Dat wordt bijvoorbeeld toegepast bij beeldherkenning. Ontwikkelaars laten dan hun basisalgoritmes los op, zeg, tien miljard foto’s om personen of objecten te identificeren. De software is zo ontworpen dat de software zelf in fases de foto’s steeds specifieker classificert, van ruwe vormen tot op het niveau van beeldpixels. Aan het einde van de rit belooft de software bijvoorbeeld om voor de mens onherkenbare personen via AI alsnog te identificeren. Vanuit dit principe plaatst de Chinese overheid momenteel twee camera’s per inwoner(!), om zo permanente beeldherkenning van burgers te verkrijgen.

Onderzoekers van het bureau voor militaire technologie van het Amerikaanse leger, DARPA, stellen dat de voorspellende waarde van AI afneemt, als je deep learning software zo moet inrichten dat mensen de patroonherkenning kunnen begrijpen. Waar het Amerikaanse leger en de Chinese overheid nu nog ongecontroleerd hun gang kunnen gaan, overtreed je in Europa de wet.

Want als je in Europa geautomatiseerd persoonsgegevens analyseert, geeft privacywet AVG de betrokken persoon het recht op een verklaring van de systeemlogica en de mogelijkheid tot correctie en verwijdering van persoonsgegevens. En in een recente zaak over de geautomatiseerde WOZ-waardebepaling van een woning formuleerde de Hoge Raad een nu al historische nieuwe rechtsregel: bij zulke geautomatiseerde besluitvorming ‘moet het bestuursorgaan zorgdragen voor de inzichtelijkheid en controleerbaarheid van die keuzes, aannames en gegevens.’ DARPA voorzag al dat Amerikaanse technologie lastig te slijten zou zijn in Europa, dus heeft het in 2016 een reusachtig onderzoeksprogramma opgezet onder de titel ‘Explainable AI’. Het model van het winnende onderzoeksteam moet binnenkort klaar zijn, wordt in 2020 getest en moet in 2021 gereed zijn.

Heilige graal

Het verenigen van uitlegbaarheid en voorspelbaarheid is de heilige graal om AI en vooral deep learning te laten landen in de samenleving. Hierbij ligt de sleutel in het onderscheid tussen de testfase (vooraf niet uitlegbaar) en implementatie (achteraf wel verklaarbaar) en transparantie.

Hoe dat ook zij, twintig jaar na dato lijkt Latour’s uitspraak de toekomst van AI in China en de VS te voorspellen. Gelukkig biedt het recht in Europa bescherming tegen obscure AI.

dysfunkcja erekcji